Deep learning for accelerated all-dielectric metasurface design

——||导读||——

本文题为《深度学习用于加速全介质超表面设计》,是美国杜克大学2019年9月16日发表在OPTICS EXPRESS上的文章。

——||背景||——

深度学习近年来在许多领域都走在了前沿,克服了许多传统方法难以解决的问题。材料的发现和优化就可以用这样的方法,但也存在数据集要求量大、反向问题中的一对多映射等挑战。全介质超表面(All-dielectric metasurfaces, ADM)与金属同类产品相比具有更多的实用性。例如,没有欧姆损耗,可能具有较低的热导率,可以在高温下生存;它的操作和性能不基于电导率,因此避免了一些约束。本文利用深度神经网络建立了一个用于全介质超表面系统模型。

——||创新||——

本文开发了一个深度神经网络(DNN),可以解决超表面设计的正向问题:给定任何几何形状(x),预测相应的S参数(s),即 x→s。文章还设计并实现了一种解决超表面设计反问题的方法:给定所需的S参数频谱(以s ∗表示),找到几何形状(以x ∗表示),即s ∗→x ∗,称为快进字典搜索(fast forward dictionary search,FFDS)。

——||图文一览||——

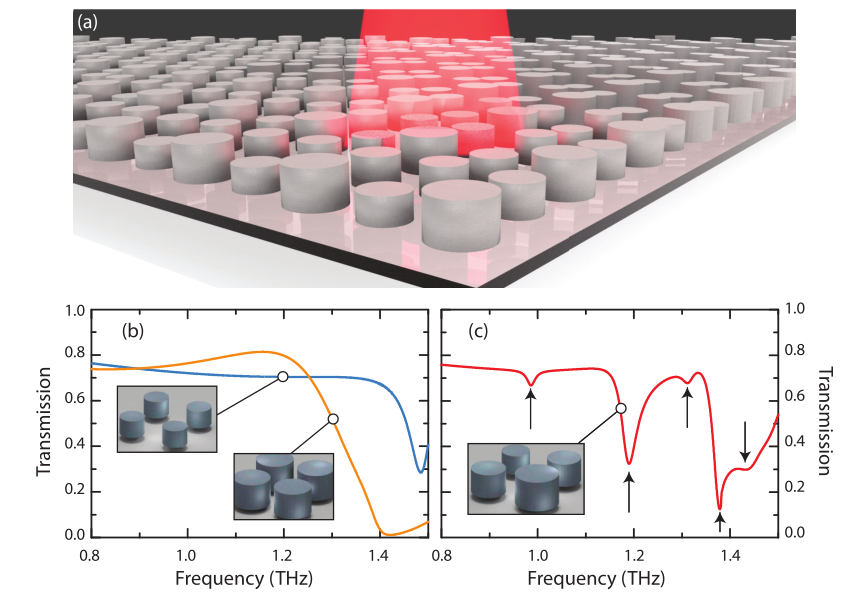

图一 超表面示意图:

(a) 由圆柱单元结构的方形阵列组成的全介电超表面的图示。

(b) 单一单元结构的透射光谱的示意图,分别为r=44.5μm,h=30μm(橙色曲线)和r=44.5μm,h=42.5μm(蓝色曲线)。

(c) 由三个r=44.5µm、h=30µm的圆柱体和一个r=44.5µm、h=42.5µm的圆柱体组成的2×2的单元结构的T(ω)。黑色箭头表示结果(a)中不存在的模式。

结论:原则上可以将单个单元结构组合在一起来实现功能,但是,与基于金属的超材料不同, ADM的单元结构具有渐逝模式的尾部,该尾部与相邻单元形成耦合,类似于介电波导中的渐逝和耦合。从理论上讲,这些频谱特征的复杂性可以用于更复杂的频率相关的散射设计,如果使用更大的单元结构,则可以进一步扩展。

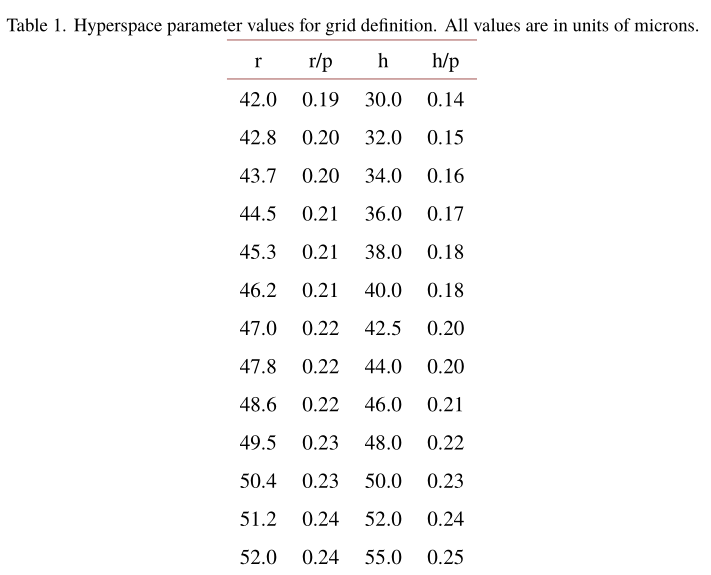

于是,本文使用2×2的单元结构作为周期。通过半径和高度(两个参数)对每个单元结构圆柱体进行参数化,从而生成一个8维参数x。为了避免在任何几何子集上对DNN的性能产生不利影响(从而对其他几何形状造成负面影响),我们通过随机采样整个几何空间来构建训练集。表一为13组供选参数,理论上可以生成138组可能的几何结构。在网络的训练过程中发现数据集到21,000时,MSE就足够小,因此文章中共选用21,000组数据,其中18,000组用来训练,3,000组用来验证。这大约是所有可能性(138)的0.0022%。

表一

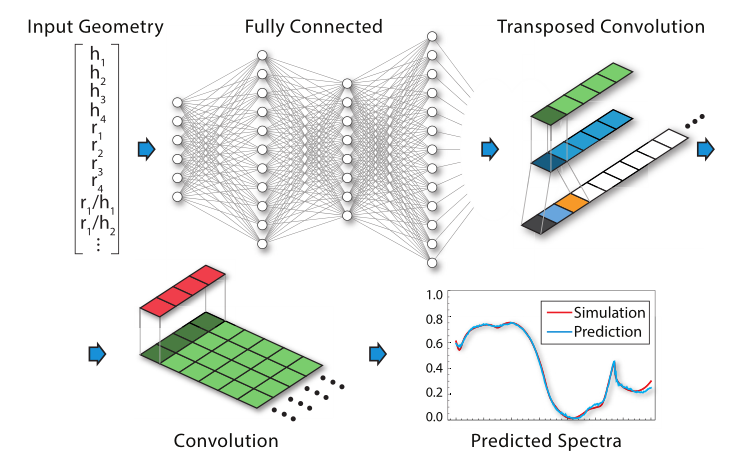

图二 神经网络架构图示:

输入层为几何尺寸,馈送到全连接层,然后通过转置卷积层(最上一行)对数据进行平滑和上采样。最后一层(底行)是一个卷积层,会产生一个预测的光谱,显示为蓝色曲线。

网络在输入层加入了多余的物理量,并假设得出的输入量对计算超表面的S参数可能是必要的或有用的。虽然DNN仍可以通过训练来逼近这些功能,但这样做需要许多额外的网络参数,这往往会增加参数推论(即优化)的难度,从而导致较差的性能。因此,在了解基础物理知识的前提下,预先计算这些数量可能会改善网络性能。经实验验证发现增加比率作为输入,可以将DNN的准确性提高约12%。

在DNN中有九个完全连接的层,其大小分别为{100,500,1000,1500,500,2000,1000,500,165}。全连接将24输入向量转换为长度165的输出向量。

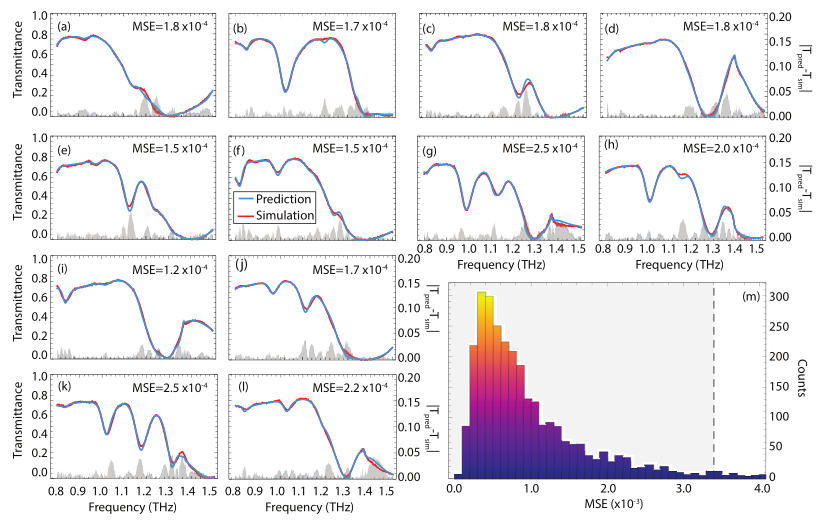

图三 网络训练结果:

a-i为频率相关的透射率(蓝色曲线)和模拟的T(ω)光谱(红色曲线)的网络预测,证明了对各种光谱特征和输入几何参数的预测精度良好。平均MSE列在每个子图中,阴影灰色区域显示了预测和模拟透射率之差的绝对值,即|Tpred-Tsim|,显示在右侧的垂直轴上。在(m)中显示了验证集中所有几何结构的MSE直方图,其中95%的MSE≤3.4×10-3,如垂直虚线灰色所示。

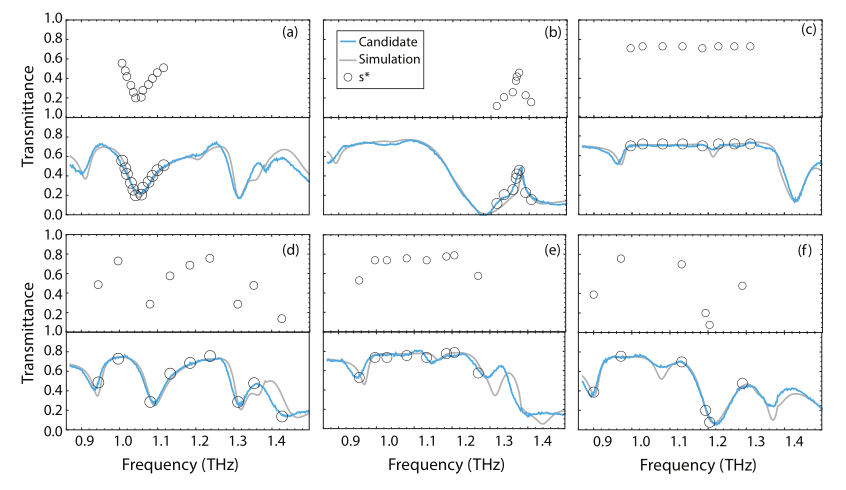

图四 反向设计问题:

文章解决反向问题的方法称为快速前向字典搜索(FFDS),利用标准GPU上的深度神经网络的超高效处理能力。为了解决反问题,我们生成了超网格上几何参数的所有组合所给出的整个光谱集,共138≈81.57亿个光谱。这是可行的,因为在Tesla Quadro M6000 GPU上,我们能够每秒计算约9,400个光谱(sp / s),从而能够在相对较短的时间内找到大量几何输入值的T(ω)。

——||结论||——

文章设计并实现了一个深度神经网络,能够在给定8个几何参数的情况下准确预测所有介电超表面的频率相关传输。介电超表面由四个圆柱结构组成的阵列,每个圆柱结构可能具有不同的半径和高度值。这个问题很难用传统的计算方法解决,并且缺乏完整的方法物理理论。我们的DNN以约9400频谱/秒的速率计算频谱,因此比在相同硬件上运行的常规电磁求解器快大约8. 2×105倍。

文章可供我们借鉴的地方有:

1. 输入数据:使用几何参数以及由集合参数得到的隐含参数作为输入,可以减轻网络训练的负担从而提高精度。

2. 网络结构:使用9个全连接层来训练网络,可借鉴。在全连接层之后连接转置卷积层和卷积层来预测输出而不是直接用全连接层。

文章来源:https://www.osapublishing.org/DirectPDFAccess/510FC33D-D1AD-7638-3928ECFFCBE1A282_418820/oe-27-20-27523.pdf?da=1&id=418820&seq=0&mobile=no

报告人:安希鹏,硕士研究生。